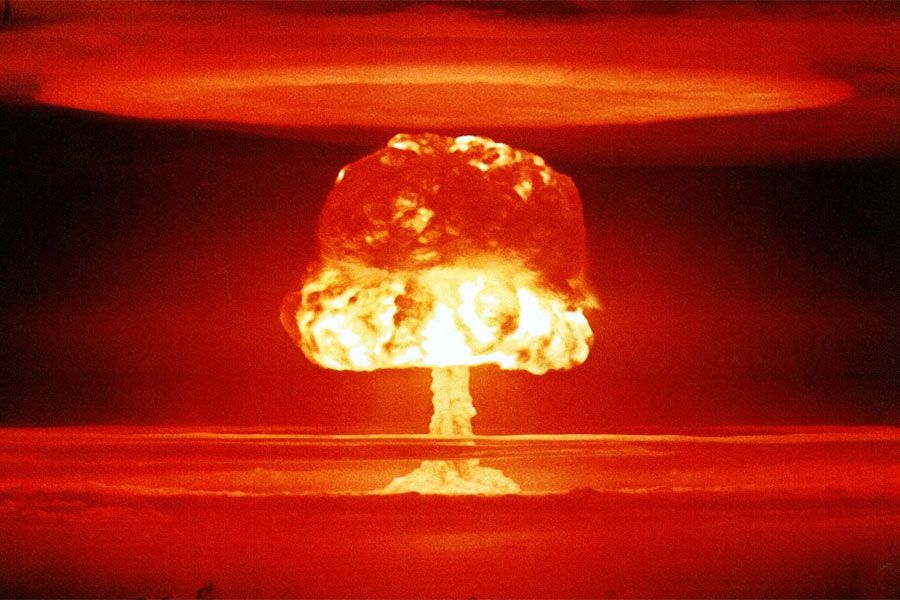

Advierten que en 20 años la inteligencia artificial pondrá en peligro la estabilidad nuclear

Un informe señala que aunque las "máquinas del fin del mundo" son improbables, los riesgos para la seguridad nuclear sí son parte del potencial que alienta a los humanos a tomar riesgos apocalípticos.

La inteligencia artificial, la misma que ha sido tomada con recelo por decenas de científicos por su peligro -incluyendo al fallecido Stephen Hawking-, nuevamente ha sido parte de una investigación que advierte sobre el potencial de desestabilizar el armamento nuclear para el año 2040.

De acuerdo a RAND Corporation, institución parte de las Fuerzas Armadas de Estados Unidos, el aprendizaje automático de estos sistemas enfocado en acciones militares implica que cualquier garantía de estabilidad global podría romperse. El documento señala además que si bien es poco probable que alguna vez se desarrollen "máquinas del fin del mundo" controladas por inteligencia artificial, la seguridad nuclear sí podría verse comprometida, debido a su potencial para "alentar a los humanos a asumir riesgos potencialmente apocalípticos".

"Algunos expertos temen que una mayor dependencia de la inteligencia artificial pueda conducir a nuevos tipos de errores catastróficos", señala Andrew Lohn, coautor del trabajo e ingeniero de RAND.

En el informe, Rand cita un evento ocurrido el 26 de septiembre de 1983, cuando el teniente coronel Stanislav Petrov se encontraba al mando de un búnker secreto en las afueras de Moscú, controlando un banco de computadoras que monitoreaba cualquier lanzamiento de misiles por parte de EE.UU., en plena Guerra Fría.

De improviso se disparó una alarma que interrumpió la tranquila rutina, mostrando una palabra en la pantalla de su computador: "Lanzamiento", lo que implicaba que desde el otro lado del Atlántico se había enviado un misil rumbo a Moscú.

Petrov diría más tarde que sabía que el sistema informático tenía problemas técnicos. Los soviéticos, preocupados por quedarse atrás en la carrera armamentista con EE.UU., estrenaron la computadora sólo unos meses antes. Aunque la pantalla de Petrov decía "Alta Confiabilidad", su instinto apuntaba todo lo contrario.

El programa en la computadora continuó, indicando que se habían lanzado misiles desde EE.UU., con cinco de ellos dirigiéndose hacia la URSS. Sin embargo, los técnicos le aseguraban a Petrov que no podían encontrar los misiles en el radar.

Finalmente, Petrov evitó la guerra nuclear gracias a que mantuvo la calma hasta el último momento, y no envió la señal de respuesta para también responder con misiles.

"El vínculo entre la guerra nuclear y la inteligencia artificial no es nueva, de hecho, los dos tienen una historia entrelazada", señaló Edward Geist, coautor e investigador en RAND.

De acuerdo a Geist, gran parte del desarrollo inicial de la inteligencia artificial se realizó con objetivos militares en mente, y es por esto que muchos líderes empresariales y científicos advierten contra su uso en un entorno militar.

Muchos investigadores, en defensa de la inteligencia artificial, afirman que con futuras mejoras en su tecnología será posible desarrollar sistemas menos propensos a errores que los humanos, ayudando a que se mantengan estables. Sin embargo, no existe claridad sobre el tiempo entre el desarrollo y hasta que la inteligencia artificial haya llegado a la madurez.

"Expertos temen que una mayor dependencia de la inteligencia artificial pueda conducir a nuevos tipos de errores catastróficos", aseguró Andrew Lohn. "Puede haber presión para usar esta tecnología antes de que esté tecnológicamente madura".

Los investigadores de RAND basaron su perspectiva en la información recopilada durante una serie de talleres con expertos en asuntos nucleares, ramas gubernamentales, investigación sobre IA, política de AI y seguridad nacional.

Fuente: RAND

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.