Cuando la IA amenaza la verdad: ¿Qué son los deepfakes y cómo pueden desinformar con personas ficticias?

Un canal de Youtube que difunde desinformación con presentadores creados con Inteligencia Artificial puso en evidencia los riesgos y límites éticos de las nuevas tecnologías. ¿Es posible prevenir o legislar para evitar ser engañados por un software?

Lo de “ver para creer” pierde su peso con rapidez. La inteligencia artificial (IA) trajo una serie de avances acelerados en la tecnología, pero también trajo una serie de desafíos que pone en jaque, incluso, la capacidad de discriminar entre lo genuino y la información creada para desinformar. Tal como se descubrió que Venezuela se ha esmerado en crear plataformas digitales que simulan ser medios de comunicación reales, pero que en realidad comparten información falsa a través de avatares creados por computador.

Un vocero de la organización Cazadores de Fake News, Héctor Mazarri, fue el que denunció ante el diario El País que el canal de Youtube, House of News Español, se trataba en realidad de un noticiario con caras y voces completamente desarrolladas con IA. Este tipo de programas realizados solo a través de la programación se conocen como “deepfakes”. Pero ¿Qué tanto pueden burlar la credibilidad de quienes vean este tipo de contenidos en la web? ¿Existe alguna forma de evitar la proliferación de discursos engañosos que son creados bajo el anonimato de un software de programación?

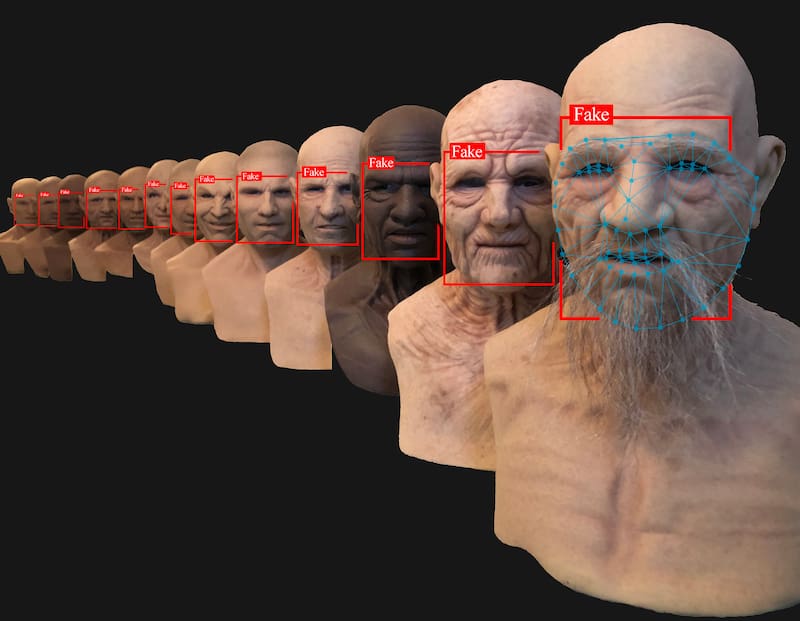

Pero antes, es necesario explicar qué son los deepfakes y cómo estos operean. Generalmente son videos, imágenes o audios generados que imitan la apariencia y el sonido de una persona. También se les conoce como “medios sintéticos” y muchas veces son tan convincentes para imitar lo real que puede engañar tanto a las personas como a los algoritmos. Son, en su mayoría generados por IA, y sus formas más comunes de aplicación son videos o como filtros de realidad aumentada.

En el caso de los videos de House of News, sus supuestos presentadores que hablan en inglés, parecen estar en un estudio televisivo y hablan con seguridad acerca de temas como la economía de Venezuela, son en realidad personajes creados con un software llamado Synthesia. Este programa, que cuenta con un centenar de rostros humanos, pueden reproducir a partir de un texto escrito un discurso con diferentes voces, acentos, idiomas y atuendos.

“Deepfake” como término proviene de la combinación de las palabras “deep learning” y “fake”, para representar algo falso que es el resultado de la tecnología de aprendizaje profundo. Si bien existe un mercado creciente de aplicaciones de consumo que utilizan tecnología deepfake para el entretenimiento, como FaceSwap, era cosa de tiempo que esto se implementara con fines no benévolos.

Además, este tipo de video están constantemente mejorándose y complejizando sus sistemas para burlar la percepción de la audiencia, o de otros algoritmos con inteligencia artificial que se encargan de detectar deepfakes. Utilizando el aprendizaje profundo y las redes adversarias generales (GAN) dos redes neuronales compiten entre sí, donde el objetivo de una es generar una imagen que la otra no podrá distinguir a partir de sus datos de entrenamiento, y el objetivo de esta última es evitar ser engañado de esta manera.

“Existió un software que hace unos años detectaba el deepfake dependiendo de los patrones de parpadeos de las personas. Cuando era demasiado ‘regular’ no se condecía con los patrones normales de un ser humano. Pero dos o tres meses después, los softwares y las mismas aplicaciones introdujeron un algoritmo que incorporaba el patrón de parpadeo humano, e inmediatamente el programa para detectar deepfakes quedó obsoleto”, explica Francisco Bedecarratz, director del Observatorio de Ciberseguridad y Coordinador del Programa de Doctorado en Derecho de la Universidad Autónoma de Chile.

Debido a que tergiversan convincentemente la realidad, los deepfakes vienen con varios peligros, incluido el fraude en línea, la desinformación, los engaños y la suplantación de rostros en videos pornográficos. ¿Existe un modo de prevenir este tipo de información engañosa?

Legislación y prevención de deepfakes

“Esta tecnología, al igual como con casi todas las que aparecen en la historia, nacen en contextos donde regulatoriamente no hay nada escrito”, asegura Bedecarratz.

Según detalla el investigador, existían ciertas regulaciones en cuanto a los computadores, al uso de la red, pero en cuanto a la creación de contenido “original” a través de entes que no son humanos no había nada escrito en los primeros años de la década del 2000. Recién en 2015 empezaron a existir regulaciones en la materia.

“A medida de que empezaron a masificarse, en 2016 y 2017, existía poco y nada de regulación en la materia. Y si no está la legislación ¿Qué se está haciendo? Tenemos algo de regulación ética que pueda encausar de alguna manera el desarrollo de esta tecnología”, explica.

Asimismo, el ingeniero en IA e investigador del Centro Nacional de Inteligencia Artificial, Cristian Irribarra, manifiesta que “es un tema super complejo y urgente. Hay varias empresas y organizaciones que trabajan en esto porque se requiere una legislación urgente”. Según cuenta, los deepfakes son la forma más visible y visceral para evidenciar estas cosas, porque son videos que nos pueden engañar, pero son totalmente ficticios. “Cualquier persona puede subir este tipo de cosas sin un respaldo real”, acusa el experto en IA.

Frente a la lentitud de los Estados en la regulación y legislación, algunas organizaciones supraestatales, ONG, empresas y organizaciones de la sociedad civil han creado parámetros y listados de lineamientos éticos que regulan la inteligencia artificial. Estos los publican como “directrices éticas sobre Inteligencia Artificial”, y son básicamente documentos que listan principios y lineamientos éticos en cuanto a el desarrollo y el uso de estos algoritmos y sistemas de IA, de los cuales crean deepfakes.

Allí se norma, por ejemplo, en cuanto al uso de armas autónomas letales, los sistemas de algoritmos de selección de personal en una empresa que permiten filtrar cuáles son los perfiles más atractivos para cada postulación. O, también, un algoritmo que se dedica a revisar cuál es el índice de reincidencia de un criminal para poder evaluar si se le da o no libertad condicional, que se aplica ahora en Estados Unidos.

El experto en Ciberseguridad de la Universidad Autónoma agrega que los cinco principios que han determinados, los más relevantes, son: Transparencia, es decir los resultados de la IA y los conjuntos de datos que gobiernan las decisiones que lo fundan tienen que ser revisados y explicados transparentemente a sus usuarios de esta tecnología. Justicia: no puede un algoritmo de IA discriminar de manera arbitraria. Seguridad, no puede ser maléfica o en detrimento de una persona. No puede usarse con fines maliciosos, y eso incluye el uso de armas autónomas o cualquier acción dentro de una guerra cibernética. Responsabilidad: es necesario saber quién está detrás de un algoritmo y poder pedirle explicaciones, y tengo que poder concurrir en derecho en contra del autor, si es que ese algoritmo me genera daño. El último principio es la Privacidad: es decir el algoritmo de IA no puede utilizar de manera desautorizada los datos personales y no pueda infringir mi privacidad en ese sentido.

Sin embargo, el problema es que la naturaleza de estas directrices habla sobre cómo tiene que actuar en ciertas situaciones. “Pero sabemos que no tienen ninguna forma de ejecutarse en la práctica de manera estricta”, enfatiza Bedecarratz.

¿Cómo se combaten los deepfakes?

En la comunidad mundial, Estados Unidos, China, la UE, la OCDE y organizaciones de la sociedad civil se han puesto más menos de acuerdo en estos principios, “pero el cumplimientos de estos son absolutamente voluntarios”, insiste. No existe responsabilidad para los desarrolladores o usuarios por el uso irresponsable, o inseguro o con la violación de la privacidad de esos algoritmos por vía propia. Según agrega el también doctor en Derecho, la forma de atacar estas situaciones es a través de un recurso de protección o a través del delito de injurias en caso de que se suplante la cara de una persona en el cuerpo de otro individuo.

“Si es que usan la cara de alguien y la suplantan en un actor de un video pornográfico, por ejemplo, eso genera injurias y se puede accionar. Pero cuando existe un noticiario cuando no se sabe quién es el que está dando la noticia es difícil o imposible accionar por una injuria, una estafa o una suplantación porque el rostro es enteramente generado de manera artificial. No hay un individuo mencionar, entonces habría que actuar desde un punto de vista colectivo, a través de la responsabilidad política”, complementa Bedecarratz.

China sacó en 2020 una regulación que, en principio, obliga a que los videos que utilizan deepfakes deben anunciar que el video está realizado con personas que no son reales. En Estados Unidos, por su lado, existen algunos estados que están prohibiendo este tipo de herramientas por su potencial vulneración de personas, especialmente en la elaboración de videos pornográficos con caras suplantadas.

“En Texas tienen una ley que prohíben los deepfakes utilizados para influenciar en las elecciones; California también tiene una ley que utiliza deepfakes de forma maliciosa dentro de 60 días antes de una elección y también la pornografía no consensuada, al igual que en el estado de Virginia. Pero no existen leyes generales en EE.UU., tampoco en Chile y en Latinoamérica”, complementa el experto en Derecho.

Por otro lado, el desarrollo de programas antagonistas para detectar cuando un video es creado por algoritmos con IA también va a la par de la evolución de deepfakes. Microsoft y Meta, por ejemplo, han dedicado últimamente sus esfuerzos en desarrollar herramientass para determinar cómo se está generando el desarrollo de estos videos falsos. Pero, “al igual que un antivirus, estos se van desarrollando a medida de que el virus logra burlar sus barreras”, complementa Irribarra.

La proliferación de deepfakes, tanto con objetivos difamadores o propagandísticos, se analizan, incluso, como si fueran una poderosa arma de una guerra cibernética. Es más a principios de 2022, pocos días después del inicio de la invasión rusa a Ucrania, se difundió un video falso donde aparecía supuestamente el mandatario Volodimir Zelenski, haciendo un llamado a sus tropas de rendirse.

Bedecarratz espera que con el tiempo aparezcan más regulaciones y leyes sobre este tema, tanto en Chile como en resto del mundo. “Chile publicó una política sobre el desarrollo de la IA hace apenas dos años. Esto va eventualmente a derivar en normativas positivas, actos de regulación, y van a existir cada vez más leyes que regulen esto”, agrega.

Sin embargo, espera que esas futuras leyes no se traduzcan en normas que prohíban la realización de este tipo de videos, ya que “si existe regulación que no sea “de camisa de fuerza” y termine matando esta tecnología en Chile, que migre a otros países donde no esté tan regulada y que finalmente no hayamos desarrollado mecanismos para poder detectar adecuadamente estos deepfakes. Porque si no se desarrollan, no vamos a poder crear estas redes antagónicas para revisar, testear y comprobar si es un video genuino o falso, y vamos a estar totalmente expuestos”, concluye.

Lee también en Qué Pasa:

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

1.

2.

3.

4.

5.

6.