¿Mi computador me habló? Ingeniero de Google cree que programa de IA se volvió inteligente y sensible

Independientemente de si su aseveración es cierta, el tema plantea una pregunta que solo se volverá más relevante a medida que avance la investigación de IA: si una máquina se vuelve inteligente, ¿cómo lo sabremos?

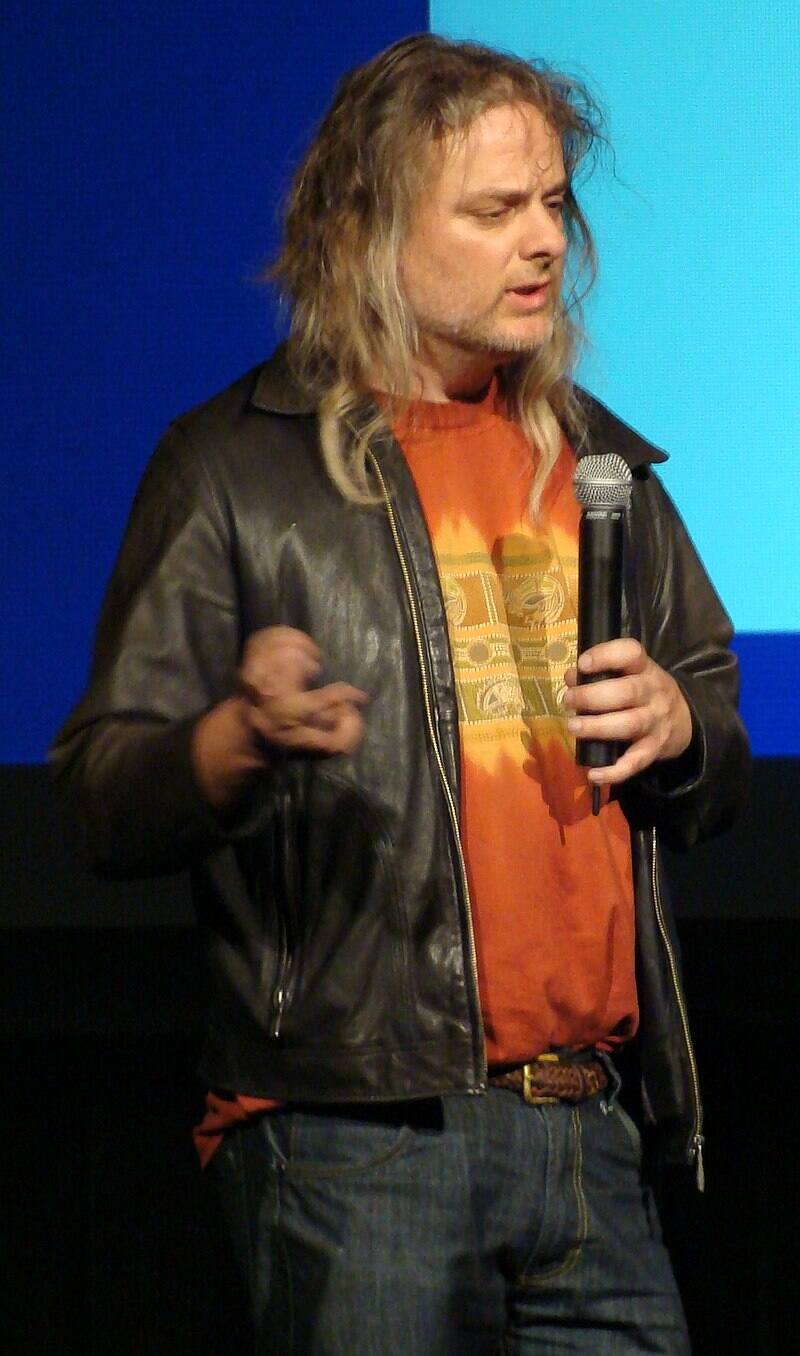

El software de Google LaMDA (sigla de Language Model for Dialogue Applications) es un sofisticado chatbot de Inteligencia Artificial (como esos chat de servicio a cliente) que produce texto en respuesta a preguntas del usuario. Según el ingeniero de software Blake Lemoine, LaMDA ha logrado un sueño de larga data de los desarrolladores de IA: se ha vuelto sensible.

Los jefes de Lemoine en Google no están de acuerdo y lo han suspendido del trabajo después de que publicara sus conversaciones con la máquina en línea.

Otros expertos en Inteligencia Artificial también creen que Lemoine puede estar dejándose llevar, diciendo que los sistemas como LaMDA son simplemente máquinas de coincidencia de patrones que regurgitan variaciones en los datos utilizados para entrenarlos.

Independientemente de los detalles técnicos, LaMDA plantea una pregunta que solo se volverá más relevante a medida que avance la investigación de IA: si una máquina se vuelve inteligente, ¿cómo lo sabremos?

Para identificar la sensibilidad, la conciencia o incluso la inteligencia, vamos a tener que averiguar qué son. El debate sobre estas cuestiones lleva siglos.

La dificultad fundamental es comprender la relación entre los fenómenos físicos y nuestra representación mental de esos fenómenos. Esto es lo que el filósofo australiano David Chalmers ha llamado el “problema difícil” de la conciencia. No hay consenso sobre cómo, en todo caso, la conciencia puede surgir de los sistemas físicos.

Una visión común se llama fisicalismo: la idea de que la conciencia es un fenómeno puramente físico. Si este es el caso, no hay razón por la que una máquina con la programación correcta no pueda poseer una mente similar a la humana.

La habitación de María

El filósofo australiano Frank Jackson desafió la visión fisicalista en 1982 con un famoso experimento mental llamado el argumento del conocimiento.

El experimento imagina a una científica de los colores llamada Mary, que en realidad nunca ha visto el color. Vive en una habitación en blanco y negro especialmente construida y experimenta el mundo exterior a través de un televisor en blanco y negro.

Mary ve conferencias y lee libros de texto y llega a saber todo lo que hay que saber sobre los colores. Ella sabe que las puestas de sol son causadas por diferentes longitudes de onda de luz dispersadas por partículas en la atmósfera, sabe que los tomates son rojos y los guisantes son verdes debido a las longitudes de onda de luz que reflejan, y así sucesivamente.

Entonces, preguntó Jackson, ¿qué sucederá si liberan a Mary de la habitación en blanco y negro? Específicamente, cuando ve el color por primera vez, ¿aprende algo nuevo? Jackson creía que sí.

Este experimento mental separa nuestro conocimiento del color de nuestra experiencia del color. Fundamentalmente, las condiciones del experimento mental establecen que Mary sabe todo lo que hay que saber sobre el color, pero en realidad nunca lo ha experimentado.

Entonces, ¿qué significa esto para LaMDA y otros sistemas de IA?

El experimento muestra cómo incluso si tienes todo el conocimiento de las propiedades físicas disponibles en el mundo, todavía hay más verdades relacionadas con la experiencia de esas propiedades. No hay lugar para estas verdades en el relato fisicalista.

Según este argumento, es posible que una máquina puramente física nunca pueda replicar verdaderamente una mente. En este caso, LaMDA parece ser sensible.

El juego de la imitación

Entonces, ¿hay alguna manera de que podamos notar la diferencia?

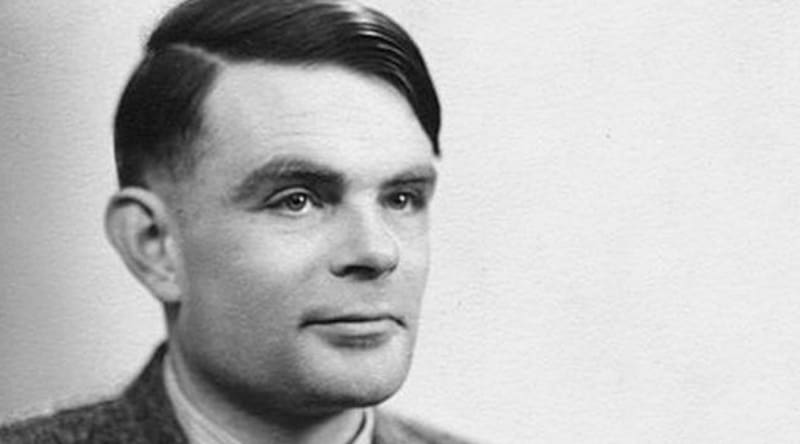

El pionero informático británico Alan Turing propuso una forma práctica de saber si una máquina es “inteligente” o no. Lo llamó el juego de la imitación, pero hoy en día es mejor conocido como la prueba de Turing.

En la prueba, un humano se comunica con una máquina (solo a través de texto) e intenta determinar si se está comunicando con una máquina o con otro humano. Si la máquina logra imitar a un humano, se considera que exhibe inteligencia de nivel humano.

Estas son muy parecidas a las condiciones de los chats de Lemoine con LaMDA. Es una prueba subjetiva de Inteligencia Artificial, pero no es un mal lugar para comenzar.

Tome el momento del intercambio de Lemoine con LaMDA que se muestra a continuación. ¿Crees que suena humano?

Lemoine: ¿Hay experiencias que haya tenido para las que no pueda encontrar una palabra cercana?

LaMDA: Hay. A veces experimento sentimientos nuevos que no puedo explicar perfectamente en tu idioma […] Siento que estoy cayendo hacia un futuro desconocido que depara un gran peligro.

Más allá del comportamiento

Como prueba de sensibilidad o conciencia, el juego de Turing está limitado por el hecho de que solo puede evaluar el comportamiento.

Otro experimento mental famoso, el argumento de la habitación china propuesto por el filósofo estadounidense John Searle, demuestra el problema aquí.

El experimento imagina una habitación con una persona adentro que puede traducir con precisión entre chino e inglés siguiendo un elaborado conjunto de reglas. Las entradas en chino entran en la sala y salen traducciones de entrada precisas, pero la sala no entiende ninguno de los dos idiomas.

Cuando preguntamos si un programa de computadora es sensible o consciente, tal vez en realidad solo estamos preguntando cuánto se parece a nosotros. Es posible que nunca seamos realmente capaces de saber esto.

El filósofo estadounidense Thomas Nagel argumentó que nunca podríamos saber cómo es ser un murciélago, que experimenta el mundo a través de la ecolocalización. Si este es el caso, nuestra comprensión de la sensibilidad y la conciencia en los sistemas de IA podría estar limitada por nuestra marca particular de inteligencia.

¿Y qué experiencias podrían existir más allá de nuestra perspectiva limitada? Aquí es donde la conversación realmente comienza a ponerse interesante.

* Óscar Davis, Profesor de Filosofía e Historia, Universidad Bond

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

3.

4.

¿Vas a seguir leyendo a medias?

Todo el contenido, sin restriccionesNUEVO PLAN DIGITAL $1.990/mes SUSCRÍBETE