Por Qué Pasa de La Tercera

Por Qué Pasa de La Tercera¿Qué te provoca esta imagen? Científicos estudian cómo una IA puede despertar emociones en la gente

Según explica el investigador, este tipo de avances sería un significativo aporte en modelos de acompañamiento de adultos mayores o personas en situación de vulnerabilidad física, mental y emocional.

Un estudio colaborativo interacadémico de la Universidad Adolfo Ibáñez y la Universidad de Córdova, aplicó herramientas de la Inteligencia Artificial (IA) para desarrollar una encuesta que interpreta emociones a partir de la percepción de obras artísticas digitalizadas, denominado “arte generativo”.

El modelo fue testeado mediante una encuesta aplicada a 61 personas de siete países, incluyendo a 33 hombres y 28 mujeres, los cuales determinaron en forma independiente; su evaluación y respuesta emocional. Sus conclusiones permiten proyectar la utilidad de este método para interpretar cambios emocionales en personas vulnerables que viven aisladas para prestar ayuda oportuna.

¿Qué te provoca esta imagen? Científicos estudian cómo una IA puede despertar emociones en la gente

La investigación fue liderada en Chile por Miguel Carrasco, académico de la Facultad de Ingeniería y Ciencias UAI, junto a Raúl Dastres, magíster en Ciencias de la Ingeniería UAI, en colaboración con el Dr. César González-Martín, investigador de la Facultad de Ciencias de la Educación y Psicología de la Universidad de Córdova.

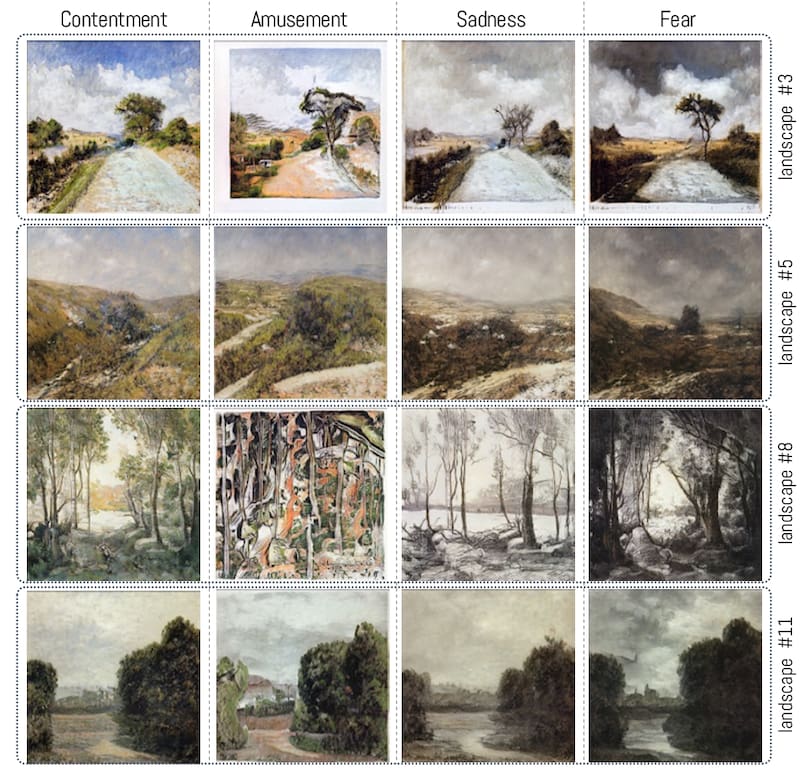

Los investigadores desarrollaron un algoritmo que genera la emoción (StyleGan ADA2) y fue entrenado con datos reales en donde muchos participantes señalaron una determinada emoción para un mismo cuadro o imagen. De este modo, el algoritmo es capaz de generar imágenes artificiales lo más cercanas a dicho entrenamiento.

Para Carrasco, la ventaja de esta herramienta es que todas las imágenes son completamente inventadas (no existen en la realidad), de modo que los observadores del estudio no las han visto nunca, garantizando que la evaluación de dichas imágenes es ciega, dado que el observador no conoce a priori una asignación a una determinada emoción. Luego, los investigadores analizaron distintas herramientas estadísticas para clasificar por género, área de estudio, nivel de formación, entre otras segmentación con el fin de encontrar si existe un patrón en los datos que indique alguna preferencia.

El estudio busca comprender cómo el arte generativo puede evocar emociones en los espectadores y teorizar respecto a que las imágenes artificiales generan una respuesta en el observador según la emoción con la cual ha sido generada.

Los investigadores esperan desarrollar e implementar una nueva metodología para estudiar las emociones en el arte generativo. “Utilizando herramientas de la inteligencia artificial, generamos 20 paisajes artificiales para luego crear cuatro versiones emocionales de cada paisajes: alegre, divertido, triste y temeroso. En total, se replicaron 80 imágenes inspiradas en la pintura, para evocar sentimientos en los encuestados”, señala Carrasco.

En cuanto a los hallazgos, en primera instancia analizaron la concordancia en las respuestas entre los participantes. En este punto concluyeron que cuando las emociones se separan en positivas y negativas existe un alto nivel de acuerdo, sin embargo cuando se dividen en las cuatro categorías emocionales, disminuye el nivel de acuerdo, independientemente del nivel de segmentación (genero, área de estudio, nivel de formación profesional).

“Este hallazgos se explica por el alto nivel de subjetividad al interpretar una emoción a partir de una imagen. Sin embargo, la parte más relevante del estudio tiene relación con el nivel de acuerdo de cada participante con relación a la imagen generada artificialmente. En este caso, se presenta un alto nivel de acuerdo cuando las imágenes se separan en positivas y negativas, y decae cuando las separamos en cuatro emociones. No obstante, es interesante revelar que las emociones negativas (triste y temeroso) son más fáciles de interpretar por los observadores en comparación con las positivas (alegre, divertido)”, precisa Carrasco.

En el largo plazo, Miguel Carrasco explica que esperan mejorar los modelos que permiten generar emociones acorde a la interpretación humana, ello porque el área de las emociones es muy subjetiva y los modelos debieran capturar los elementos esenciales de dicha subjetividad para incluir la mayor cantidad de elementos visibles y/o interpretables en un observador.

“Este punto tiene verdadero valor en la medida que a futuro, este tipo de herramientas permita a una máquina interpretar imágenes o videos del mismo modo que un observador humano lo hace. Este tipo de avances sería un significativo aporte en modelos de acompañamiento remoto de adultos mayores o personas en situación de vulnerabilidad física, mental y emocional”, sostiene el profesor UAI.

El estudio actualmente se encuentra en proceso de revisión a la espera de ser publicado en alguna revista científica internacional y socializados sus resultados en congresos.

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

1.

3.

4.

¿Vas a seguir leyendo a medias?

Todo el contenido, sin restriccionesNUEVO PLAN DIGITAL $1.990/mes SUSCRÍBETE