Siri de Apple ya no es una mujer por defecto, pero ¿es realmente una victoria para el feminismo?

Aunque ahora son los usuarios quienes deben decidir el género del popular asistente de voz, aún persisten una serie de sesgos de género detrás de este programa.

A partir del 31 de marzo de 2021, cuando Apple lanzó la actualización beta de iOs 14.5 para su sistema operativo, Siri ya no usa una voz femenina por defecto cuando usa inglés americano. Los usuarios ahora deben elegir entre dos voces masculinas y dos femeninas al habilitar el asistente de voz. Este movimiento podría interpretarse como una respuesta a la reacción violenta contra el sesgo de género encarnado por Siri.

Pero, ¿qué tan significativo es este cambio realmente?

Siri ha sido criticado por encarnar varias facetas del sesgo de género en la inteligencia artificial. Los sociólogos digitales Yolande Strengers y Jenny Kennedy argumentan que Siri, junto con otros asistentes de voz como Alexa de Amazon y Google Home, se han desarrollado para “llevar a cabo el ‘trabajo de esposa’: deberes domésticos que tradicionalmente han recaído en esposas (humanas)”.

Siri originalmente solo se expresó como mujer y estaba programada no solo para realizar tareas de “esposa”, como verificar el clima o configurar una alarma matutina, sino también para responder con coquetería. El uso de frases sexualizadas por Siri ha sido ampliamente documentado por cientos de videos de YouTube con títulos como “Cosas que NUNCA deberías preguntarle a SIRI” (que tiene más de 18 millones de visitas).

Apple ha sido criticada por promover una imagen sexualizada y estereotipada de la mujer que daña negativamente las normas de género. Una investigación de 2019 realizada por The Guardian revela que Apple escribió pautas internas en 2018 pidiendo a los desarrolladores que hagan que Siri desvíe las menciones al feminismo y otros “temas sensibles”. No está claro cuáles fueron las pautas para los regresos coquetos de codificación rígida.

El lenguaje utilizado por Siri era (y sigue siendo) una combinación de un modelo de lenguaje ya estereotipado, que incluye bromas codificadas por los desarrolladores. Un análisis de 2016 de los modelos de lenguaje populares utilizados por las empresas de software señaló que las asociaciones de palabras eran muy estereotipadas. En el estudio, términos como “filósofo” y “capitán” tenían el género masculino, mientras que lo contrario para términos como “ama de casa”.

La académica jurídica Céline Castets-Renard y yo hemos estado estudiando los modelos de lenguaje utilizados por Google Translate y Microsoft Bing que han revelado problemas similares. Ingresamos frases neutrales al género en mandarín romanizado en las plataformas de traducción, lo que obliga a los algoritmos de traducción a seleccionar el género en inglés y francés. Sin excepción, el algoritmo de Google seleccionó pronombres masculinos y femeninos a lo largo de líneas estereotipadas de género. El algoritmo de Microsoft, por el contrario, selecciona exclusivamente pronombres masculinos.

El uso de modelos como estos en el algoritmo de Siri podría explicar por qué, cuando escribe cualquier título corporativo (director ejecutivo, director financiero, etc.), se propondría un emoji masculino. Si bien esto se ha abordado desde entonces, probablemente debido a las críticas, en el último iOS, si se le pide a Siri que recupere una foto de un capitán o un programador, las imágenes mostradas siguen siendo una serie de hombres.

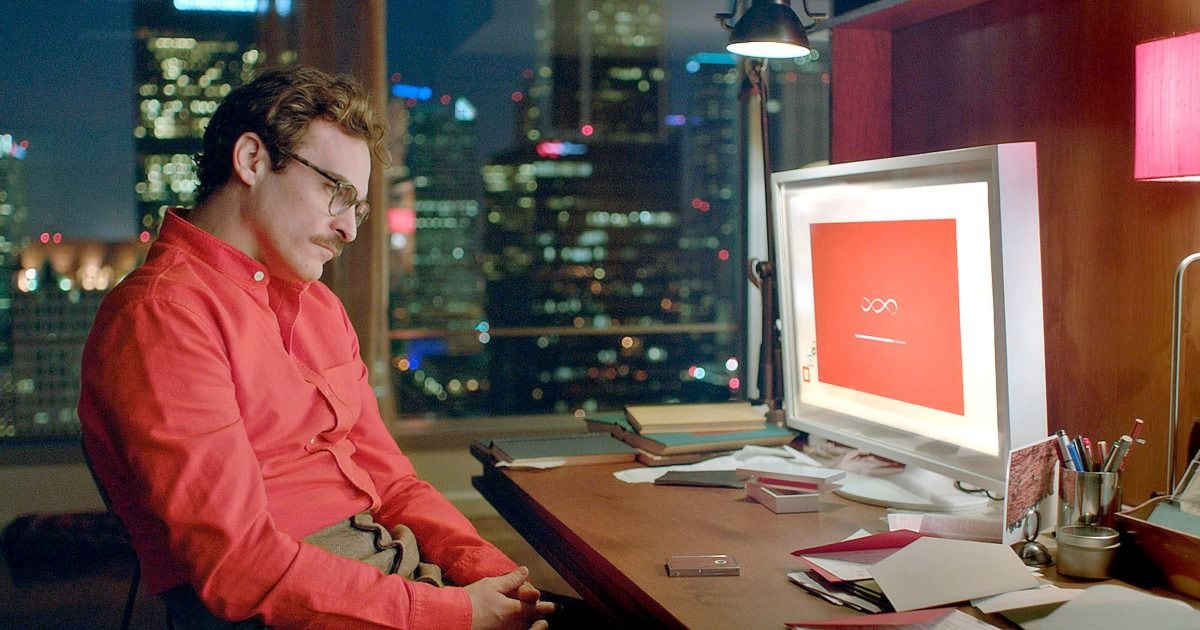

La idea del asistente virtual perfectamente coqueto inspiró la película Her de 2013 de Spike Jonze, en la que el protagonista masculino se enamora de su asistente virtual. Pero es difícil imaginar cómo los modelos de lenguaje sesgados podrían hacer que un asistente virtual coqueteara con los usuarios. Es probable que esto haya sido intencional.

En respuesta a estas críticas, Apple eliminó progresivamente algunos de los rasgos más flagrantes y aparentemente codificó algunas de las respuestas más ofensivas a las preguntas de los usuarios. Esto se hizo sin hacer demasiadas olas. Sin embargo, el registro de videos de YouTube muestra a Siri cada vez menos sexista.

Una de las últimas críticas restantes fue que Siri tenía una voz femenina, que siguió siendo la predeterminada a pesar de que también se proporcionó una voz masculina como una opción desde su lanzamiento en 2011. Ahora, los usuarios deben decidir por sí mismos si quieren una voz femenina o masculina.

Sin embargo, los usuarios no conocen el modelo de lenguaje en el que está entrenado el asistente virtual, o si todavía quedan legados de la coqueta Siri en el código.

Empresas como Apple tienen una gran responsabilidad en la configuración de las normas sociales. Un informe de los medios públicos nacionales de 2020 reveló que durante la pandemia, el número de estadounidenses que utilizan asistentes virtuales aumentó del 46 al 52 por ciento, y esta tendencia solo continuará.

Además, muchas personas interactúan con asistentes virtuales abiertamente en su hogar, lo que significa que las IA sesgadas interactúan con frecuencia con los niños y pueden sesgar su propia percepción de las relaciones humanas de género.

Eliminar la voz femenina predeterminada en Siri es importante para el feminismo porque reduce la asociación inmediata de Siri con las mujeres. Por otro lado, también existe la posibilidad de utilizar una voz de género neutro, como la que lanzó en 2019 un grupo liderado por Copenhagen Pride.

Cambiar la voz de Siri no aborda los problemas relacionados con los modelos de lenguaje sesgados, que no necesitan una voz femenina para ser utilizada. Tampoco aborda el sesgo de contratación en la empresa, donde las mujeres solo representan el 26 por ciento de los roles de liderazgo en investigación y desarrollo.

Si Apple va a continuar eliminando silenciosamente el sesgo de género de Siri, todavía queda bastante trabajo por hacer. En lugar de hacer cambios pequeños y graduales, Apple debería abordar el tema de la discriminación de género de frente y distinguirse como líder.

Permitir que grandes porciones de la población interactúen con una IA sesgada amenaza con revertir los avances recientes en las normas de género. Por lo tanto, lograr que Siri y otros asistentes virtuales estén completamente libres de sesgos debería ser una prioridad inmediata para Apple y los otros gigantes del software.

* Profesora adjunta, responsable de IA, Universidad de Ottawa

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.