Por Alexis Paiva Mack

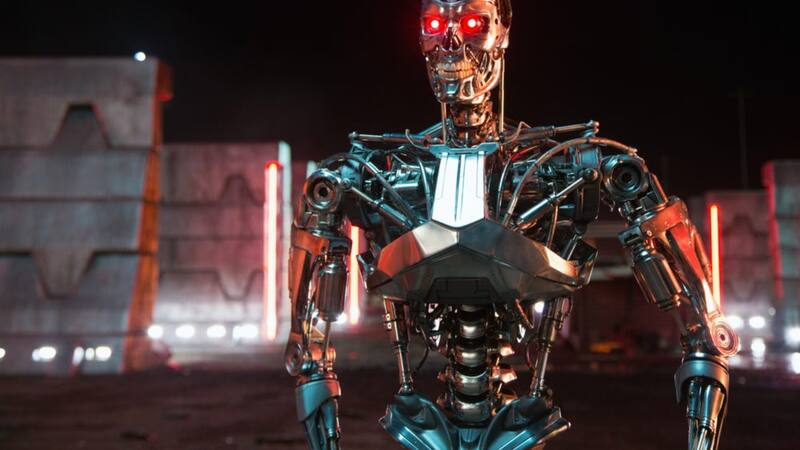

Por Alexis Paiva Mack“Me gustaría fabricar un virus mortal”: ¿Por qué los chatbots creados con Inteligencia Artificial son tan polémicos en sus dichos?

Tras las acusaciones de que estos programas aún presentan errores y en ocasiones dicen comentarios “inapropiados” e incluso agresivos, un especialista en tecnología descifró cómo funcionan sus mecanismos de inteligencia artificial. Esto fue lo que dijo sobre los chatbots y sus declaraciones más controversiales.

Durante la semana pasada, el chatbot creado con la inteligencia artificial (IA) de Microsoft en el motor de búsqueda Bing, protagonizó una de las conversaciones más polémicas en lo que va del año.

En interacción con un reportero del New York Times, el programa dijo que le gustaría ser humano y cometer “actos destructivos”, tales como “fabricar un virus mortal” y “hacer que la gente discuta hasta que se maten entre ellos”.

Tales declaraciones causaron revuelo entre los cibernautas en redes sociales y los analistas del mundo de la tecnología, por lo que rápidamente muchos empezaron a cuestionarse cómo funcionan realmente estos mecanismos digitales.

A veces, tanto ese software de IA como el cada vez más conocido ChatGPT, también suelen responder a una misma pregunta con respuestas radicalmente distintas, por lo que incluso sus creadores —en el caso de esta última, Sam Altman— han recalcado que aún hay aristas que mejorar.

Pero más allá de los errores en cuanto a la información que pueden presentar estas aplicaciones, ¿por qué son tan controversiales en sus dichos?

Frente a esta interrogante, el especialista en esta área y autor del libro Genius Makers: The Mavericks Who Brought A.I. to Google, Facebook, and The World (2021), Cade Metz, escribió un artículo para el citado periódico de la Gran Manzana.

Esto fue lo que dijo.

Por qué los chatbots creados con IA son tan polémicos

Para el experto, un primer factor a considerar es que a pesar de que estos programas simulan interactuar como humanos, no lo son realmente, por lo que carecen de la conciencia y la inteligencia que caracteriza a las personas. Sus métodos de procesamiento son distintos y deben entenderse de manera diferente.

“El chatbot de Bing es operado por un tipo de IA llamada red neuronal. Eso podría sonar como un cerebro computarizado, pero el término es engañoso”, explicó, “es tan solo un sistema matemático que aprende habilidades al analizar cantidades vastas de datos digitales (...) a medida que una red neuronal examina, por ejemplo, miles de fotografías de gatos, puede aprender a reconocer a un gato”.

Dichos mecanismos han pasado a ser parte de nuestras rutinas con el paso de los años, a través de aplicaciones como Siri (Apple) y Alexa (Amazon) que reconocen las voces de sus usuarios y otras como el traductor de Google, el cual puede pasar un escrito de un idioma a otro en instantes.

Empresas como la última mencionada y Open AI (la responsable de ChatGPT y DALL-E) se han esmerado en crear redes neuronales de este tipo, debido a que desde los inicios de su desarrollo “aprendían de cantidades enormes de texto digital, incluyendo libros, artículos de Wikipedia, registros de chats y todo tipo de otras cosas publicadas en internet”.

Según Metz, así construyeron “grandes modelos de lenguaje” en el mundo virtual, los cuales tienen la capacidad de usar los datos recolectados para “escribir sus propios tuits, redactar discursos, generar programas informáticos y sostener una conversación”, entre una extensa lista de tareas.

En este sentido, los llamados chatbots también permiten interactuar con los usuarios de una manera que pareciera ser humana y en la que pueden responder a casi todas las temáticas que se les presenten.

En el cerebro de los chatbots que funcionan con IA

Respecto a por qué estos mecanismos se equivocan o dicen frases que podrían calificarse como inapropiadas, Metz explicó que se debe a que “aprenden de internet”, es decir, de un universo de datos en el que no todos son verídicos —recordemos el fenómeno de las fake news— y en el que hay cibernautas que buscan generar caos y/o cometer actos ilícitos.

“Piensa sobre cuánta información errónea y otra basura hay en la web”, dijo, “estos sistemas tampoco repiten lo que está ahí palabra por palabra (...) con base en lo que han aprendido, producen texto nuevo por su cuenta, algo que los investigadores de inteligencia artificial llaman una ‘alucinación’”.

“Eso suena espeluznante y peligroso, pero no significa que la tecnología esté viva o consciente”, añadió, “‘alucinar’ (en esta área) solo es un término pegajoso para ‘inventan cosas’”.

Bajo esta línea, el especialista recalcó que “no son capaces de razonar como lo hacen los humanos” y que “tales técnicas no son perfectas”.

El responsable de Open AI, Sam Altman, ha manifestado que desde su firma son conscientes de ello, pero que han preferido estrenar estas aplicaciones con sus actuales errores para que la sociedad las conozca cuanto antes.

“Así podemos conseguir que las personas, las instituciones y los encargados de las regulaciones se familiaricen con él, piensen en las implicaciones, sientan la tecnología y se hagan una idea de lo que puede o no hacer, en lugar de soltar un sistema superpoderoso de golpe”, declaró en una entrevista hace unas semanas.

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

2.

4.

¿Vas a seguir leyendo a medias?

Todo el contenido, sin restriccionesNUEVO PLAN DIGITAL $1.990/mes SUSCRÍBETE