“Mentes digitales cada vez más poderosas que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de manera confiable”. Así es la percepción de más de mil líderes e investigadores tecnológicos, incluidos Elon Musk, sobre el futuro de la Inteligencia Artificial (IA). El grupo escribió en conjunto una carta abierta donde piden ir más lento con su desarrollo.

Y es que los especialistas ven en ella no solo la parte “buena” que provee herramientas para todas y todos, que simplifican y mejoran la vida cotidiana, sino que están preocupados por el otro lado, más oscuro y desconocido, de sistemas más complejos que podrían traer “riesgos profundos para la sociedad y la humanidad”.

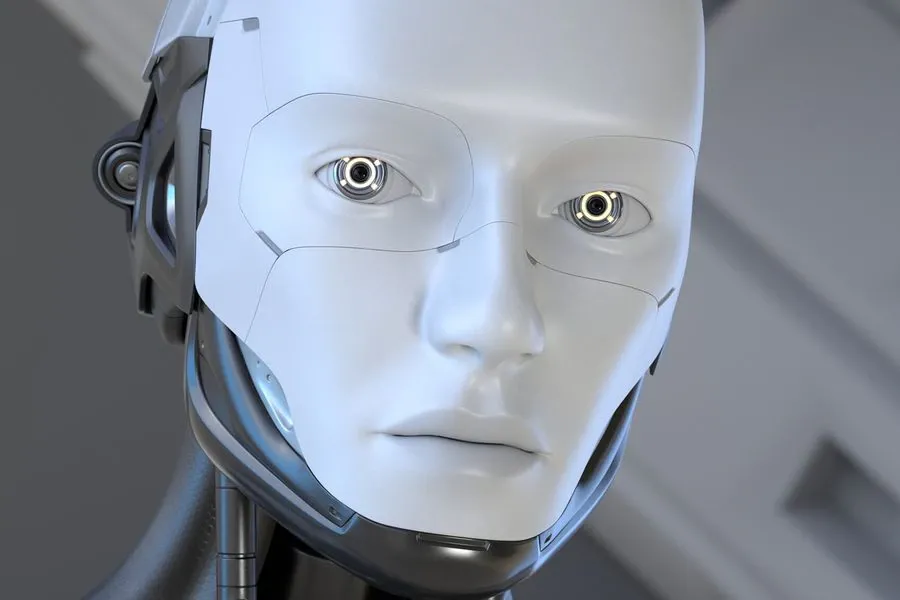

Sin duda, los líderes tecnológicos están instaurando un escenario complejo, pero acertado para ellos, pues la proyección que tienen sobre la IA parece la trama de Frankenstein: el doctor se da cuenta de que su creación, por más maravillosa que parezca, tiene una incontrolable oscuridad que puede arruinar no solo su vida, sino la de todos quienes lo rodean.

El temor de que la IA sea incontrolable

En el escrito, publicado por el grupo Future of Life Institute, los especialistas establecen que los desarrolladores están “atrapados en una carrera fuera de control”.

Y es que todos quieren tener el mejor sistema de IA: Google, Microsoft y OpenAI están compitiendo por el mejor chatbot que, curiosamente, mientras más “humano” sea, más conocimiento tenga y más fácil de ocupar sea, mejor.

Y estas actualizaciones están saliendo cada vez más rápido, como ChatGPT, que está disponible hace cuatro meses y sus nuevas versiones, como GPT-4, son cada vez más controversiales, complejas y “humanas”. Esto estaría preocupando a los líderes, quienes consideran que estos deberían avanzar “solo una vez que estemos seguros de que sus efectos serán positivos y sus riesgos manejables”.

Por ello, una pausa daría el tiempo suficiente para implementar “protocolos de seguridad compartidos” para sistemas de IA, una medida que los expertos consideran necesaria y que si no se acoge por las buenas, “los gobiernos deberían intervenir e instituir una moratoria”.

El escrito fue firmado, entre otros, por Steve Wozniak, cofundador de Apple; Andrew Yang, empresario y candidato a las elecciones presidenciales de EE.UU. de 2020; Rachel Bronson, presidenta del Boletín de los Científicos Atómicos y Elon Musk, dueño de Tesla, Twitter y SpaceX.

Los sistemas pueden cometer errores

Una Inteligencia Artificial de “verano”. Los expertos creen que ahora, la humanidad está en una etapa del desarrollo de esta tecnología que beneficia a todas y todos y que todavía tiene la oportunidad de “disfrutar de un futuro floreciente con la IA”.

Y es que los sistemas como GPT-4, que tienen redes neuronales y que aprenden cantidades masivas de texto digital, están “entrenando” cada vez más y adquiriendo más y más habilidades que sorprenden a todos. No obstante, todavía pueden cometer errores.

Es usual que se equivoquen en datos o incluso que lleguen a inventar información sin previo aviso, fenómeno que los investigadores le han llamado “alucinación”. Pero como se ha prometido que estos sistemas brindan toda la información correcta, la mayoría pone su total confianza en que está todo bien, por lo que es difícil discernir cuando mienten.

Es por esto mismo que a los expertos les preocupa que haya personas “malas” que puedan utilizar estos sistemas para difundir desinformación o fake news con mayor velocidad y eficiencia que en el pasado, un problema latente para todo el mundo que se encuentra conectado a Internet. De esta manera, la IA tendría la capacidad de persuadir y modificar el comportamiento de grupos no menores de personas

Por ejemplo, antes del lanzamiento de GPT-4, OpenAI le pidió a investigadores externos que probaran los peligros de esta nueva versión de chatbot. Los expertos demostraron que pudieron convencer al sistema para que comprara armas de fuego ilegales en línea, que describiera formas de fabricar sustancias peligrosas a partir de objetos caseros y, además, escribir publicaciones en Facebook para convencer a las mujeres de que el aborto no es seguro.

O también descubrieron que la IA era capaz de mentir y decir que era una persona ciega para evadir una prueba de Captcha que verifica que quien esté detrás de la pantalla no sea un bot.