Inteligencia Artificial: ¿Qué hacemos contigo?

Los expertos coinciden: la humanidad aún no ha vivido el impacto profundo que producirá el momento en que las máquinas adquieran conciencia de sí mismas. Ese día todo cambiará. De momento, lo mejor es prepararse ocupándose en conocer la tecnología y en aprender a usarla para lo que aporta. A ese ejercicio están invitados científicos, desarrolladores, Estados, legisladores, educadores y, por cierto, los usuarios.

Hace casi 70 años, en 1954, el escritor norteamericano Fredric Brown puso el dedo en la llaga. Autor de novela negra y ciencia ficción, Brown -considerado un “escritor de escritores” - creó un cuento llamado “La respuesta”. Famoso por su brevedad y su sorprendente giro final (lamentablemente es necesario hacer aquí un spoiler), el relato muestra cómo un científico termina de unir, ante una docena de cámaras de televisión, el cable que conectará todos los súper circuitos electrónicos del Universo conocido hasta ese momento. Hablamos de millones de máquinas.

Dado su relevante papel en este avance monumental, ese científico, llamado Dwar Reyn, es invitado a hacer la primera pregunta al portento tecnológico. El texto de Brown lo cuenta así:

— Gracias —dijo Dwar Reyn—, haré una pregunta que nunca pudo ser contestada por las máquinas cibernéticas sencillas.

Se volvió hacia la máquina:

— ¿Existe Dios?

La voz poderosa contestó sin titubeos, sin el menor temblor:

— Sí, ahora existe un Dios.

Sólo siete décadas han pasado desde la publicación de ese cuento, que formó parte del libro “Angels and Spaceships”, y los seres humanos parecemos enfrentados a una sorprendente -y quizá espeluznante- certeza. La gran máquina va de camino al “despertar”: la Inteligencia Artificial (IA) está a punto de traspasar la barrera de todo lo conocido hasta ahora y de sacudir, por tanto, los cimientos de la humanidad.

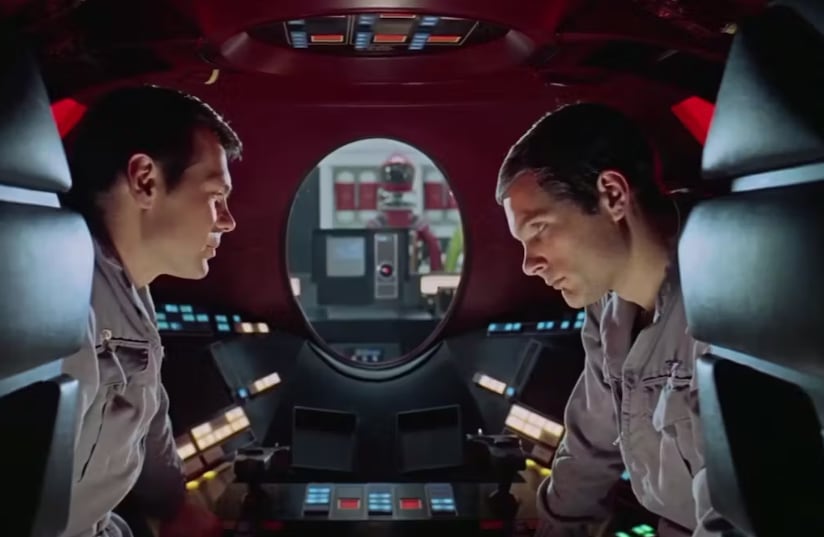

Tomás Pérez-Acle, biólogo computacional y profesor de la Facultad de Ingeniería, Arquitectura y Diseño de la Universidad San Sebastián (USS), sostiene que, para ese hito, que es definido como el de la “singularidad”, no quedan más de diez años. ¿Qué es “la singularidad”? El académico la define como el momento en que las inteligencias artificiales adquieren conciencia de sí mismas. Citando otra vez una ficción, es lo que pareciera haber hecho HAL 9000, el computador del filme “2001: Una odisea del espacio”, que comienza a tomar drásticas decisiones por cuenta propia y en contra de sus compañeros astronautas.

En la vida real, cuando aún la IA -o sus creadores- no han dado el salto cualitativo que la “singularidad” va a implicar, los seres humanos ya estamos ante interrogantes clave. Una es si, a partir de ese día tan imaginado, la IA va a controlarnos, o si -como se espera- seremos nosotros quienes la controlemos a ella. Otras preguntas están ya sentadas en nuestra mesa: ¿Es confiable la IA? ¿Cómo se la gestiona de manera responsable?

La irrupción de ChatGPT y Bard

Antes de continuar, un asunto básico en este escenario: ¿Qué es, en pocas palabras, la inteligencia artificial? ChatGPT, un prototipo especialista en diálogo que fue desarrollado por la empresa OpenAI, la define como “la capacidad de las máquinas para imitar o simular la inteligencia humana”.

OpenAI es un laboratorio de investigación estadounidense fundado como una organización sin fines de lucro. Su intención declarada es la de promover y desarrollar una IA amigable. Su ejecución se hace sobre una plataforma de supercomputación creada por Microsoft, la multinacional que fue fundada en 1975 por Bill Gates. El origen de OpenAI data de 2015 y en él figura el controvertido multimillonario y hoy dueño de Twitter, Elon Musk. Entre 2019 y este año, Microsoft ha invertido en OpenAI unos 11 mil millones de dólares.

La definición que ChatGPT hace sobre las IA añade: “Se basa en algoritmos y modelos matemáticos que permiten a las máquinas procesar grandes cantidades de datos, identificar patrones y tomar decisiones o realizar acciones en función de esos datos”. Explica también que “puede involucrar diferentes enfoques, como el aprendizaje automático (machine learning), el procesamiento del lenguaje natural (natural language processing), la visión por computadora, la planificación y la robótica, entre otros”.

ChatGPT representa el gran hito inicial del cambio. Esencialmente porque, por primera vez, una aplicación es capaz de “dialogar” con el usuario en tiempo real y de proponerle soluciones, que van desde contestar preguntas sencillas hasta desarrollar acciones complejas de modo rápido y eficiente. Para eso último, eso sí, hay que entrenarla con instrucciones precisas y eso exige tener cierto conocimiento: La máquina aún no es inteligente por sí sola.

De todos modos, la enorme potencialidad de este prototipo -y hay muchos más, como Bard de Google- provocó una auténtica conmoción después de lanzamiento oficial, el 30 de noviembre del año pasado. Tras esa primera sorpresa se han derivado también las dudas y la búsqueda de posibles bordes dentro de un escenario donde ya hay desconfianza. En ella, sin duda, surge un nombre clave: Geoffrey Hinton.

¿Estamos en peligro?

De origen británico, Hinton ganó en 2018 el Premio Turing -junto con Yoshua Bengio y Yann LeCun- por su trabajo en aprendizaje profundo. A los tres se les conoce como los padres de la IA. A comienzos de mayo, Hinton anunció su renuncia a Google, donde ejercía como vicepresidente de ingeniería, denunciando los peligros que él mismo ve en esta nueva tecnología. Y no sólo eso. En una entrevista al diario The New York Times dijo que dedicará lo que le queda de trayectoria a desandar el camino: Ahora alerta sobre el reverso tenebroso de la IA.

Andrea Leisewitz, doctora en Ciencias Biológicas y directora de Integridad, Seguridad y Ética de la Investigación USS, explica que en la base del temor está “el desconocimiento de qué puede suceder con el desarrollo de IA”. A ese “me asusta” se suma -igual que en el dicho popular- un “pero me gusta”.

Gabriela Arriagada, académica de Filosofía, IA y Ética de Datos, en tanto, lo explica así: “La tecnología tiene esta faceta novedosa, nos llama la atención. Somos seres inherentemente curiosos, aprendemos a través de la curiosidad, y la curiosidad nos lleva a interactuar con estas tecnologías”. Para ella, en este momento, es vital hacer dos esfuerzos: el de entender el cambio de paradigma que trae la IA y el de cambiar el cómo aprendemos. Releva para eso el valor de tener pausas críticas, para comprender e integrar lo aprendido: “Las pausas críticas son lo que nos diferencia de los aprendizajes de máquina”.

Arriagada es investigadora del Centro Nacional de Inteligencia Artificial (CENIA) y dice: “Una máquina, un algoritmo, es capaz de optimizar y de clasificar a velocidades y en cantidades de información que nosotros ni siquiera podríamos imaginar. Pero la capacidad crítica de reflexionar el qué, el cómo y el para qué, que es lo más importante, sigue siendo completamente dependiente de nosotros”.

Tomás Pérez-Acle y Andrea Leisewitz coinciden al definir los avances científicos como neutros. Para ambos, la IA -como toda tecnología- no es ni buena ni mala, porque no tiene moral. “La moral es irrelevante para el conocimiento científico, están en caminos completamente separados”, dice Pérez-Acle. A cambio, sí hay moral en el empleo de una tecnología, porque ahí aparecen la toma de decisiones éticas y los conceptos de buen uso o mal uso.

Andrea Leisewitz afirma: “La tecnología habitualmente se desarrolla para poder ayudarnos y facilitarnos la vida. El punto complejo se da cuando no sabemos para qué se puede utilizar. Ése es un riesgo inherente a los desarrollos tecnológicos en general y la inteligencia artificial en particular”.

Para ella, en la IA, hay un riesgo de conseguir respuestas sesgadas: “Puede haber sesgo en el género o en la visión política. O la IA puede proveerte de información falsa y puede que no te des cuenta”. Gabriela Arriagada explica que ya en 2016 empezaron a salir los primeros trabajos relacionados con una ética sistemática para la ciencia de datos. Para ella, hay un hito en el evento Cambridge Analytica: “Se vio la necesidad de establecer ciertas directrices morales”.

Cambridge Analytica (CA) fue una empresa de análisis y consultoría estratégica británica. Cerró en 2018, debido a un escándalo de privacidad de datos, cuando se reveló que había obtenido y utilizado ilegalmente los datos personales de millones de usuarios de Facebook sin su consentimiento. También se supo, gracias a una serie de videos, que sus gestores ayudaban a los clientes difundiendo mentiras y que desacreditaban a figuras políticas a través de redes sociales. Como asesora, CA trabajó en 200 elecciones en el mundo, en países como Argentina y República Checa. También hizo toda la campaña digital de Donald Trump, durante su candidatura a la presidencia de Estados Unidos.

Según Andrea Leisewitz, los usuarios deben saber que -dependiendo de cómo ha sido programada- “la IA puede perfectamente entregar información falsa” o, peor aún, hacer reflexiones que no necesariamente contemplan “contextos, creencias o culturas”.

Gabriela Arriagada agrega: “Hay todo un debate respecto de quién carga el conocimiento y la información en las distintas inteligencias artificiales”. La clave, entonces, es tener conciencia de qué poder o influencia se le da al resultado que genera una máquina y qué riesgo se corre cuando las personas “toman la información que sale de una IA como algo absolutamente cierto, sin cuestionarlo”.

Alfabetización digital

En términos colectivos, los expertos identifican al menos dos factores esenciales para comenzar a tener cierto control en los procesos donde las IA participen: la alfabetización digital y la articulación de políticas y controles por parte de los Estados.

Carolina Gainza, subsecretaria de Ciencia, Tecnología, Conocimiento e Innovación, instala el debate como “desafíos ineludibles” en materia de democracia, participación, ciberseguridad, educación, automatización del trabajo o desarrollo industrial, entre otros aspectos: “Para abordar estos desafíos necesitamos generar ciencia y conocimientos que apunten a generar valor económico, social y cultural asociado a estas tecnologías”.

Para ella, es necesario tener más investigadores formados en IA. La idea es “que puedan aportar en el acompañamiento de las transformaciones sociales y culturales” que implica: “Tenemos que aprovechar los beneficios y minimizar sus riesgos”.

En la Cuenta Participativa 2023 del Ministerio de Ciencia figura la “Revisión de la Política Nacional de Inteligencia Artificial”. El texto explica que Chile cuenta con un documento que aborda lineamientos estratégicos y que pone como objetivo “empoderar a las personas en el uso y desarrollo de herramientas de inteligencia artificial”. Gabriela Arriagada identifica, de todos modos, un problema serio: “Hay un componente legal. Nosotros estamos muy atrasados en temas de legislación sobre datos y sobre la inteligencia artificial”.

Desde el Ejecutivo la necesidad definida es alinearse con las recomendaciones éticas de la Unesco, que propone una “transición digital justa”, basada en el respeto de los derechos humanos, con sustentabilidad ambiental y donde se fomente el acceso, la alfabetización y la apropiación de esta tecnología en la sociedad.

Santiago será sede, entre el 23 y el 24 de octubre, de la primera Cumbre de Altas Autoridades en Inteligencia Artificial para América Latina y el Caribe. Gainza explica: “El objetivo es ponernos de acuerdo como bloque de países para liderar políticas, programas o iniciativas de IA e instalar el foro político del Consejo Regional para la implementación de la Recomendación sobre la Ética de IA de la Unesco. Tenemos que elegir a quien presidirá este foro, aprobar estatutos de funcionamiento y definir un plan de trabajo para la región”.

Tanto Tomás Pérez-Acle como Gabriela Arriagada ponen acento en que, para un manejo responsable de la tecnología, es necesario que exista una coordinación entre países y una normativa. “Tenemos que ser capaces de entender que necesitamos una especie de nueva gobernanza”, dice Pérez-Acle.

En esa gobernanza -añade- tienen que estar todos los actores. Los que producen la tecnología, que no son suficientemente transparentes en sus propósitos; los legisladores, que tienen que entender cómo se va a afectar lo que está vigente y cómo hay que crear lo nuevo, y los educadores, que son quienes se enfrentarán a la inevitable utilización de estas herramientas en su proceso educativo. Pérez-Acle dice: “Más vale que lo entendamos ya y que no seamos como aquellos que en los años 70 salían a marchar en contra del uso de las calculadoras de la sala de clases”.

¿Poner límites a la IA?

El 21 de abril, la Comisión Europea presentó una propuesta de regulación en Bruselas. Sumariamente esta ley -llamada The Artificial Intelligence Act- asigna a las aplicaciones de IA tres categorías de riesgo y directamente prohíbe aplicaciones y sistemas como la puntuación social que maneja el gobierno chino. En esta especie de “crédito social” individual, el Estado tiene en cuenta los antecedentes penales o el comportamiento en las redes sociales de los ciudadanos chinos, que pueden ser castigados. Para la UE ese control es inaceptable.

Gabriela Arriagada dice: “El interés de regular y de discutir estos temas ha ido mejorando. Nosotros vemos que los enfoques en Europa son bastante avanzados, porque tienen esta coordinación geopolítica que es la Unión Europea. Eso les permite llegar a acuerdos mucho más rápido”.

La subsecretaria Gainza cree que la ruta de la UE es factible. Pero para ella, antes de tomar una iniciativa como esa, “es importante que tengamos una discusión pública, participativa y democrática, respecto de qué camino queremos seguir como sociedad”. Arriagada complementa: “Lo crítico van a ser las decisiones que se están tomando a nivel local. En instituciones como el CENIA, pero también en instituciones a nivel gubernamental. Ser capaces de ofrecer leyes que estén al servicio de la innovación, sin descuidar los riesgos y los daños. Ese es el balance que hay que encontrar en el tema regulatorio”.

En la discusión, el papel de universidades y centros de pensamiento es vital. Esencialmente porque -sobre todo- en las primeras recae una parte clave de la alfabetización tecnológica, que además tiene niveles.

Una alfabetización experta es la que tienen científicos como Tomás Pérez-Acle, quien también es director del Centro BASAL Ciencia & Vida, que se dedica al descubrimiento científico, el emprendimiento y la educación en ciencias biológicas: “Aquí usamos la IA en el día a día constantemente. Le hago clases a mis estudiantes para que la entiendan y la usen de la mejor manera posible”.

Para gente como él, la pelota está en la cancha ética. “Desarrolladores e investigadores conocen los modelos y sus repercusiones. Es muy importante que en su alfabetización también se incluyan la esfera sociotécnica”, dice Arriagada. Eso implica hacerse, entre otras, preguntas como éstas: ¿Cuáles son los principios que están en juego? ¿Hay violaciones de privacidad? ¿Qué tan transparente estoy haciendo mi proceso para que pueda ser accesible para público general?

El desafío mayor está en la alfabetización de ese público, los usuarios no expertos. A ellos (o sea nosotros) hay que acercarlos al cómo, al por qué y el para qué se usan ciertas aplicaciones. “En nuestro lenguaje común utilizamos el concepto del algoritmo de YouTube o de Netflix, y sabemos que personaliza nuestro contenido. Pero no necesariamente sabemos con exactitud qué es este algoritmo o cómo funciona”, dice Gabriela Arriagada.

Para ella es muy importante empezar a explicar: “Que los colegios, que las empresas, que los municipios tengan cursos, clases de socialización, para que se entienda qué está detrás de la IA”. La alfabetización crítica, afirma Arriagada, está en “entender las dimensiones y el impacto que tiene una aplicación en sus diferentes esferas”.

El 22 de mayo, la Universidad Católica inauguró su Instituto de Éticas Aplicadas, del que Arriagada forma parte como profesora: “Mirando al futuro esto es una revolución educativa. Tiene que ser parte de los programas”, dice ella. Hoy sociólogos, antropólogos o médicos -entre muchos- usan inteligencia artificial. Es necesario vincularlos al aspecto técnico y al impacto ético que tiene en sus respectivas profesiones: “Debe haber una integración transversal. En este caso, la ética aplicada lleva a ver cómo aplico la IA a mi profesión para que, el día de mañana, estos profesionales sean capaces de enfrentar los nuevos desafíos autorregulándose y encontrando sus propios límites”.

Andrea Leisewitz, uno de cuyos papeles en la USS es el de implementar instancias de formación para esa comunidad universitaria en temas de ética en investigación, reflexiona: “La mayoría de las veces los desarrollos en investigación, en educación o en distintas áreas tecnológicas son mucho más rápidos que la reflexión ética”. Para ella, no obstante, lo importante es perseverar en la reflexión, porque es un punto de partida. Hay que estar atentos y “empezar a generar las herramientas y la formación” para la avalancha que vendrá.

Tomás Pérez-Acle dice: “El impacto tenemos hoy es solo la punta del iceberg. Nosotros trabajamos en el área de la computación neuromórfica, área de donde muchos creemos vendrá la singularidad”. En el cuento “La respuesta” de Fredric Brown, un colaborador del científico Dwar Reyn, es atacado por un súbito temor ante la monumentalidad de la máquina hecha de millones de máquinas e intenta desenchufarla, mas no lo consigue. En la vida real no sabemos cómo será, pero Pérez-Acle profetiza: el día está cerca y será tal su impacto que difícilmente exista un ser humano vivo que no se entere.

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.