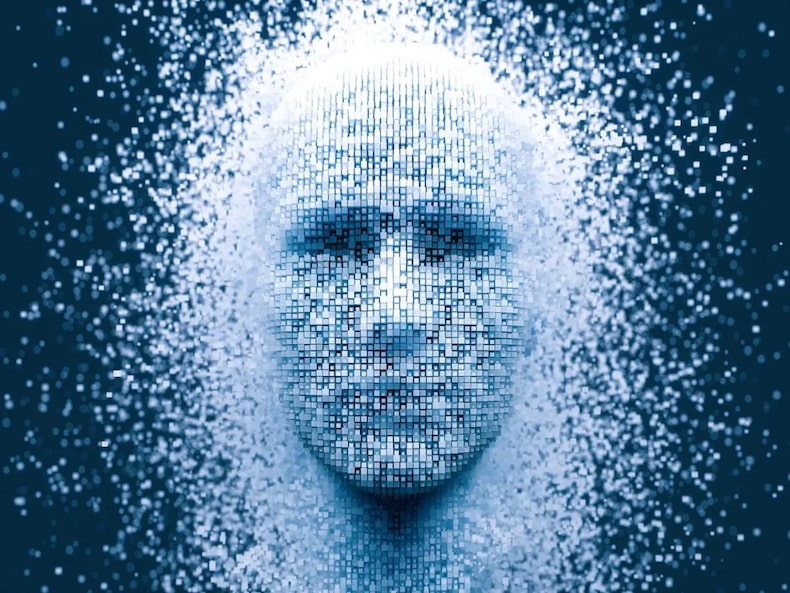

La alarmante carta de Eliezer Yudkowsky: “No basta con detener los avances de la IA, hay que pararlo todo”

El escritor y experto en Inteligencia Artificial advirtió que, de no parar el desarrollo de esta tecnología ahora, toda la humanidad está en riesgo de morir. Este es un extracto de su última carta polémica, publicada en el Time.

“Todos los laboratorios de Inteligencia Artificial pausen de inmediato, durante al menos seis meses, el entrenamiento de sistemas de IA más potentes que GPT-4″.

Ese fue el llamado de un grupo de especialistas, para darle un respiro al mundo del vertiginoso desarrollo de esta tecnología que, al no tener tantas reglas, podría provocar graves consecuencias para la humanidad.

Pero a Eliezer Yudkowsky, experto en Inteligencia Artificial y escritor reconocido, los seis meses que piden sus colegas no le pareció un tiempo suficiente porque “subestima la gravedad de la situación y pide muy poco para solucionarla”.

Y es que el hombre no teme qué podría pasar con la IA que sea “competitiva con los humanos”, sino lo que sucederá cuando esta sea más inteligente que la propia humanidad.

“Muchos investigadores que se han visto envuelto en este tema, incluso yo, creemos que el resultado más probable de construir una IA con inteligencia sobrehumana es que, literalmente, todos los habitantes de la Tierra morirán”.

Con estas palabras controversiales, Yudkowsky escribió una alarmante carta, publicada en el medio Time, sobre lo que podría pasar en el futuro, con la Inteligencia Artificial desbordada.

Qué pasará con la humanidad a manos de la Inteligencia Artificial

Eliezer Yudkowsky, creador del Instituto de Investigación de Inteligencia Artificial (MIRI, por sus siglas en inglés) aseguró en su carta que el mundo no está preparado para una tecnología tan desarrollada, que incluso supere a la inteligencia humana.

Para sobrevivir, “se necesitaría precisión, preparación y nuevos conocimientos científicos, y probablemente no contar con sistemas de IA compuestos por conjuntos gigantescos e inescrutables de números fraccionarios”.

Sin esta preparación, Yudkowsky advirtió que es probable que la IA deje de hacerle caso al humano, que no se preocupe por la humanidad ni por la vida sintiente, lo que sería “una pérdida total”.

Para ilustrar mejor el destino al que está expuesto el humano, el experto propone dejar de lado la imagen de una IA hostil que vive en Internet y que envía correos malintencionados.

En su lugar, “imaginemos una civilización alienígena entera, que piensa a una velocidad millones de veces superior a la humana, en un mundo de criaturas (nosotros) que, desde su perspectiva, son muy estúpidas y lentas”.

“Una IA lo suficientemente inteligente, no permanecerá confinada a las computadoras por mucho tiempo”.

Recientemente, OpenAI anunció GPT-5, la próxima versión de ChatGPT que traería consigo miles de funciones inteligentes nuevas. Sin embargo, la empresa declaró que, pronto, planean hacer una IA que haga la tarea de alinearse a sí misma.

“El solo hecho de escuchar que este es el plan debería ser suficiente para que cualquier persona sensata entre en pánico”.

Y es que, para el experto en IA, esta tecnología podría obrar mal, tenga o no consciencia de lo que está haciendo.

“Si no puedes estar seguro de si estás creando una IA consciente de sí misma, es alarmante, no solo por las implicaciones morales de la parte ‘consciente de sí misma’, sino porque no estar seguro significa que no tienes idea de lo que estás haciendo. Eso es peligroso y deberías parar”.

Para solucionar los problemas éticos y riesgos de esta tecnología, Yudkowsky cree que podrían pasar al menos 60 años. Pero para ello, es necesario parar todo el desarrollo de un golpe, pues intentar reparar la IA cuando ya tiene inteligencia sobrehumana podría ser también un riesgo.

“Si te equivocas al primer intento, no podrás aprender de tus errores, porque estarás muerto”, escribió.

“Muchos investigadores que trabajan en estos sistemas creen que nos estamos precipitando hacia una catástrofe, y son más los que se atreven a decirlo en privado que en público, pero creen que no pueden detener unilateralmente la caída hacia adelante, que otros seguirán adelante incluso si ellos mismos dejan sus trabajos”.

Cómo evitar la extinción de la humanidad por la IA según Yudkowsky

La propuesta de solución de Eliezer Yudkowsky es radical: el hombre solicitó que el alto al desarrollo de la IA debe ser “indefinido y de alcance mundial. No puede haber excepciones, ni siquiera para los gobiernos o los ejércitos”.

“Si la política comienza con Estados Unidos, entonces China debe ver que los EE. UU. no buscan una ventaja, sino que intentan prevenir una tecnología terriblemente peligrosa que no puede tener un verdadero dueño y que matará a todos en los EE. UU., en China y en la Tierra”.

También propuso cerrar todas las grandes granjas de computadoras “donde se perfeccionan las IA más poderosas” y poner un tope en la cantidad de poder computacional que cualquiera pueda utilizar para entrenar un sistema IA.

Además, espera que se cree alguna política en la “diplomacia internacional” para evitar los escenarios de extinción a raíz de la IA, que, según el hombre, debiese estar incluso por sobre la prevención de una guerra nuclear total.

“Y que los países aliados con armas nucleares están dispuestos a correr algún riesgo de intercambio nuclear si eso es lo que se necesita para reducir el riesgo de grandes entrenamientos de IA”.

“Ese es el tipo de cambio de política que haría que mi pareja y yo nos abrazáramos, que dijeramos que ha ocurrido un milagro y que ahora existe la posibilidad de que Nina (su hija) sobreviva. Las personas sensatas que se enteran de esto por primera vez y dicen ‘tal vez no deberíamos hacerlo’ merecen ser escuchadas”.

Para esto, el mundo necesitaría que “los responsables políticos se den cuenta de que si siguen haciendo las cosas como siempre y hacen lo que es políticamente fácil, sus hijos también van a morir. Apágalo todo (la IA). No estamos preparados, y no estamos en vías de estar más preparados en un futuro”.

“Si seguimos adelante con esto, todos morirán, incluidos los niños que no eligieron esto y no hicieron nada malo. Apágalo”, concluyó en su carta.

Este escrito de Eliezer Yudkowsky se suma a una lista de cartas polémicas y alarmantes que ha ido escribiendo desde el vertiginoso cambio que llegó con la Inteligencia Artificial. Puedes leer la carta completa haciendo click aquí.

Comenta

Los comentarios en esta sección son exclusivos para suscriptores. Suscríbete aquí.